LINUX中查看文本文件内容命令

cat:从第一行開始显示所有的文本内容;

tac:从最后一行開始,显示所有分文本内容,与cat相反。

nl:显示文本时,能够输出行号。

more:按页显示文本内容;

less:与more差点儿相同,也是按页显示文本内容,差别是less能够一行一行的回退。more回退仅仅能一页一页回退。

head:从头開始显示文件指定的行数;

tail:显示文件指定的结尾的行数。但每一行的位置还是原文件里的位置,不会像tac那样与原文件相反。

vi: NB的Linux文本编辑器。

样例与说明

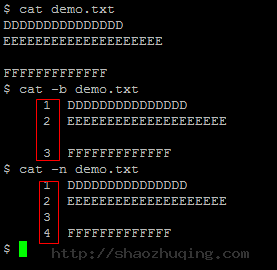

cat

- cat demo.txt

显示demo.txt文件所有内容 - cat -b demo.txt

显示demo.txt文件所有内容。非空的行输出行号。空行会输出。但不标记行号 - cat -n demo.txt

显示demo.txt文件所有内容。所有行都输出行号

长处:简单

缺点:当文本文件内容多于一页内容时。仅仅能显示出最后一页的内容,无法看到前面的内容。

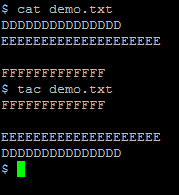

tac

- tac demo.txt

从最后一行開始。倒序输出demo.txt的内容。本人不经常使用。

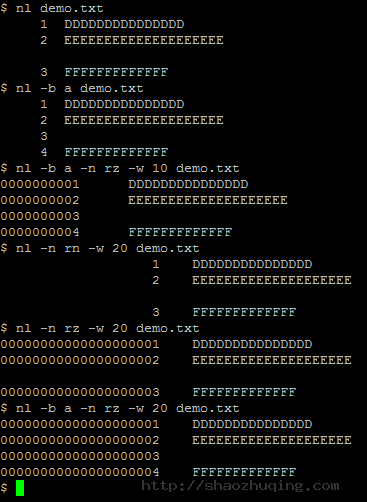

nl

- nl demo.txt

显示文件内容。顺便输出行号。默认情况下空行不记录行号 - nl -b a demo.txt

- b a #空行也输出行号

- b t #默认设置

- n ln ##行号最左方显示

- n rn ##行号最右方显示,且不加0(然并卵,我的机器上依旧显示在左边)

- n rz ##行号最右方显示,且加0(再次然并卵,但加了0了。例如以下图所看到的)

- w ##设置行号字段占用的位数

长处:貌似非常灵活的样子

缺点:就查看下内容。输出个行号而已。搞那么复杂有卵用。。。

more

- more demo.txt

- 按一下空格则往下翻一页

- 按一下Enter则往下翻一行

- 按一下B键往上翻一页

- 不能往上一行一行的翻回去了

- :f 能够显示文件名称和如今的行数

- q退出more

less

- less demo.txt

- more命令的所有按键less都支持

- ↑↓箭头能够实现一行一行的上下翻

- PageDown/PageUp能够实现一页一页的上下翻

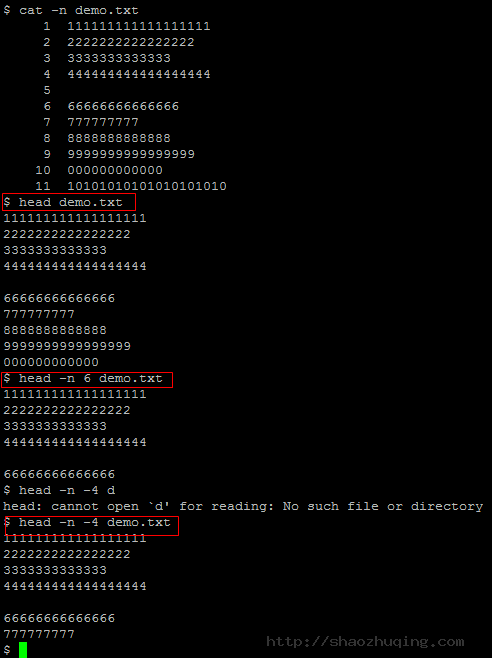

head

- head demo.txt

默认仅仅显示文件的前10行文本内容 - head -n 6 demo.txt

-n 6 參数指定显示文件的前6行 - head -n -4 demo.txt

-n -4 负数表示除去文件结尾的4行,其它的从头開始的所有行都显示出来

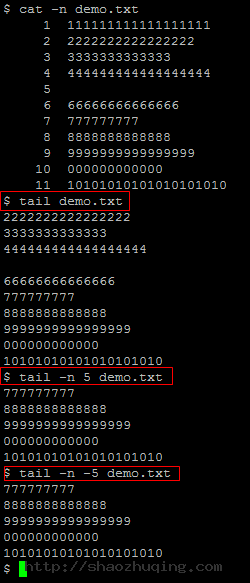

tail

- tail demo.txt

默认仅仅显示从文件最后一行開始的10行文本内容 - tail -n 5 demo.txt

-n 5 參数指定显示文件的最后5行 - tail -n -5 demo.txt

**-n -5**tail命令不支持负数。运行结果同-n 5

vi

vi命令是使用VIM文本编辑器打开文本,VIM编辑器眼下本人也是刚開始学习。仅仅记住了一些简单的命令:

- vi demo.txt 进入Normal模式查看文本

- i 进入Insert模式插入内容,编辑文本

- nG n代表行号,在Normal模式输入nG则定位到第n行

- :set number 在Normal模式输入则显示文本行号。空行也会显示行号

- ESC 退出Insert模式至Normal模式

- :wq 在Normal模式下保存退出。w保存;q退出;能够单独使用

firewalld和iptables的关系

Centos 7,发现无法使用iptables控制Linuxs的端口,而使用firewalld代替了原来的iptables

firewalld和iptables的关系

firewalld自身并不具备防火墙的功能,而是和iptables一样需要通过内核的netfilter来实现,也就是说firewalld和iptables一样,他们的作用都是用于维护规则,而真正使用规则干活的是内核的netfilter,只不过firewalld和iptables的结构以及使用方法不一样罢了。

firewalld的配置模式

firewalld的配置文件以xml格式为主(主配置文件firewalld.conf例外),他们有两个存储位置

1、/etc/firewalld/ 用户配置文件

2、/usr/lib/firewalld/ 系统配置文件,预置文件

我们知道每个zone就是一套规则集,但是有那么多zone,对于一个具体的请求来说应该使用哪个zone(哪套规则)来处理呢?这个问题至关重要,如果这点不弄明白其他的都是空中楼阁,即使规则设置的再好,不知道怎样用、在哪里用也不行。

对于一个接受到的请求具体使用哪个zone,firewalld是通过三种方法来判断的:

1、source,也就是源地址 优先级最高

2、interface,接收请求的网卡 优先级第二

3、firewalld.conf中配置的默认zone 优先级最低

这三个的优先级按顺序依次降低,也就是说如果按照source可以找到就不会再按interface去查找,如果前两个都找不到才会使用第三个,也就是学生在前面给大家讲过的在firewalld.conf中配置的默认zone。

安装firewalld,运行、停止、禁用firewalld

root执行 # yum install firewalld

启动:# systemctl start firewalld

查看状态:# systemctl status firewalld 或者 firewall-cmd --state

停止:# systemctl disable firewalld

禁用:# systemctl stop firewalld

配置firewalld

查看版本:$ firewall-cmd --version

查看帮助:$ firewall-cmd --help

查看设置:

显示状态:$ firewall-cmd --state

查看区域信息: $ firewall-cmd --get-active-zones

查看指定接口所属区域:$ firewall-cmd --get-zone-of-interface=eth0

拒绝所有包:# firewall-cmd --panic-on

取消拒绝状态:# firewall-cmd --panic-off

查看是否拒绝:$ firewall-cmd --query-panic

更新防火墙规则:# firewall-cmd --reload

# firewall-cmd --complete-reload

两者的区别就是第一个无需断开连接,就是firewalld特性之一动态添加规则,第二个需要断开连接,类似重启服务

将接口添加到区域,默认接口都在public

# firewall-cmd --zone=public --add-interface=eth0

永久生效再加上 --permanent 然后reload防火墙

设置默认接口区域

# firewall-cmd --set-default-zone=public

立即生效无需重启

打开端口(貌似这个才最常用)

查看所有打开的端口:

# firewall-cmd --zone=dmz --list-ports

加入一个端口到区域:

# firewall-cmd --zone=dmz --add-port=8080/tcp

若要永久生效方法同上

打开一个服务,类似于将端口可视化,服务需要在配置文件中添加,/etc/firewalld 目录下有services文件夹,这个不详细说了,详情参考文档

# firewall-cmd --zone=work --add-service=smtp

移除服务

# firewall-cmd --zone=work --remove-service=smtp

如何构建垂直网络爬虫平台

写一个爬虫很简单,写一个可持续稳定运行的爬虫也不难,但如何构建一个通用化的垂直网络爬虫平台?

这篇文章主要介绍垂直网络爬虫平台的构建思路。

爬虫简介

首先介绍一下什么是爬虫?

网络爬虫(又被称为网页蜘蛛,网络机器人),是一种按照一定的规则,自动地抓取网页信息的程序或者脚本。

很简单,爬虫就是指定规则自动采集数据的程序脚本,目的在于拿到想要的数据。

爬虫主要分两类:

- 通用网络爬虫(搜索引擎)

- 垂直网络爬虫(特定领域)

由于第一类的开发成本较高,故只有搜索引擎公司在做,如谷歌、百度等。

而大多数企业在做的是第二类,成本低、数据价值高。例如一家做电商的公司只需要电商领域有价值的数据,那开发一个电商领域的爬虫平台,意义较大。

这篇文章主要针对第二类的平台构建提供设计与思路。

如何写爬虫

首先从最简单的开始,我们先了解一下如何写一个爬虫?

简单爬虫

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

# coding: utf8

"""简单爬虫"""

import requests

from lxml import etree

def run():

"""run"""

# 1. 定义页面URL和解析规则

crawl_urls = [

'https://book.douban.com/subject/25862578/',

'https://book.douban.com/subject/26698660/',

'https://book.douban.com/subject/2230208/'

]

parse_rule = "//div[@id='wrapper']/h1/span/text()"

for url in crawl_urls:

# 2. 发起HTTP请求

response = requests.get(url)

# 3. 解析HTML

result = etree.HTML(response.text).xpath(parse_rule)[0]

# 4. 保存结果

print result

if __name__ == '__main__':

run()

|

这个爬虫比较简单,大致流程为:

- 定义页面URL和解析规则

- 发起HTTP请求

- 解析HTML,拿到数据

- 保存数据

任何爬虫,要想获取网页上的数据,都是经过这几步。

当然,这个简单爬虫效率比较低,只能抓完一个网页,再去抓下一个,有没有提高效率的方式呢?

异步爬虫

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

|

# coding: utf8

"""协程版本爬虫,提高抓取效率"""

from gevent import monkey

monkey.patch_all()

import requests

from lxml import etree

from gevent.pool import Pool

def run():

"""run"""

# 1. 定义页面URL和解析规则

crawl_urls = [

'https://book.douban.com/subject/25862578/',

'https://book.douban.com/subject/26698660/',

'https://book.douban.com/subject/2230208/'

]

rule = "//div[@id='wrapper']/h1/span/text()"

# 2. 抓取

pool = Pool(size=10)

for url in crawl_urls:

pool.spawn(crawl, url, rule)

pool.join()

def crawl(url, rule):

"""抓取&解析"""

# 3. 发起HTTP请求

response = requests.get(url)

# 4. 解析HTML

result = etree.HTML(response.text).xpath(rule)[0]

# 5. 保存结果

print result

if __name__ == '__main__':

run()

|

经过优化,我们完成了异步版本的爬虫代码。

由于爬虫要抓的网页一般很多,提高效率是爬虫最基本的技能,由于下载网页都是阻塞在网络IO上,那我们可以利用多线程或异步的方式,提高抓取效率。

有了这些基础知识之后,我们看一个完整的例子,如何抓取一个整站数据?

整站爬虫

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

|

# coding: utf8

"""整站爬虫"""

from gevent import monkey

monkey.patch_all()

from urlparse import urljoin

import requests

from lxml import etree

from gevent.pool import Pool

from gevent.queue import Queue

base_url = 'https://book.douban.com'

# 种子URL

start_url = 'https://book.douban.com/tag/?view=type&icn=index-sorttags-all'

# 解析规则

rules = {

# 标签页列表

'list_urls': "//table[@class='tagCol']/tbody/tr/td/a/@href",

# 详情页列表

'detail_urls': "//li[@class='subject-item']/div[@class='info']/h2/a/@href",

# 页码

'page_urls': "//div[@id='subject_list']/div[@class='paginator']/a/@href",

# 书名

'title': "//div[@id='wrapper']/h1/span/text()",

}

# 定义队列

list_queue = Queue()

detail_queue = Queue()

# 定义协程池

pool = Pool(size=10)

def crawl(url):

"""首页"""

response = requests.get(url)

list_urls = etree.HTML(response.text).xpath(rules['list_urls'])

for list_url in list_urls:

list_queue.put(urljoin(base_url, list_url))

def list_loop():

"""采集列表页"""

while True:

list_url = list_queue.get()

pool.spawn(crawl_list_page, list_url)

def detail_loop():

"""采集详情页"""

while True:

detail_url = detail_queue.get()

pool.spawn(crawl_detail_page, detail_url)

def crawl_list_page(list_url):

"""采集列表页"""

html = requests.get(list_url).text

detail_urls = etree.HTML(html).xpath(rules['detail_urls'])

# 详情页

for detail_url in detail_urls:

detail_queue.put(urljoin(base_url, detail_url))

# 下一页

list_urls = etree.HTML(html).xpath(rules['page_urls'])

for list_url in list_urls:

list_queue.put(urljoin(base_url, list_url))

def crawl_detail_page(list_url):

"""采集详情页"""

html = requests.get(list_url).text

title = etree.HTML(html).xpath(rules['title'])[0]

print title

def run():

"""run"""

# 1. 标签页

crawl(start_url)

# 2. 列表页

pool.spawn(list_loop)

# 3. 详情页

pool.spawn(detail_loop)

# 开始采集

pool.join()

if __name__ == '__main__':

run()

|

此爬虫以豆瓣图书为例,抓取整站信息,大致思路为:

- 从标签页进入,提取所有标签URL

- 进入每个标签页,提取所有列表URL

- 进入每个列表页,提取每一页的详情URL和下一页列表URL

- 进入每个详情页,拿到书名

- 如此往复循环,直到数据抓取完毕

这就是抓取一个整站的思路,很简单,无非就是分析我们浏览网站的行为轨迹,用程序来进行自动化的请求、抓取。

理想情况下,我们应该能够拿到整站的数据,但实际情况对方网站往往会采取防爬虫措施,在抓取一段时间后,我们的IP就会被禁。

那如何突破这些防爬错误,拿到数据呢?我们继续优化代码。

防反爬的整站爬虫

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

|

# coding: utf8

"""防反爬的整站爬虫"""

from gevent import monkey

monkey.patch_all()

import random

from urlparse import urljoin

import requests

from lxml import etree

import gevent

from gevent.pool import Pool

from gevent.queue import Queue

base_url = 'https://book.douban.com'

# 种子URL

start_url = 'https://book.douban.com/tag/?view=type&icn=index-sorttags-all'

# 解析规则

rules = {

# 标签页列表

'list_urls': "//table[@class='tagCol']/tbody/tr/td/a/@href",

# 详情页列表

'detail_urls': "//li[@class='subject-item']/div[@class='info']/h2/a/@href",

# 页码

'page_urls': "//div[@id='subject_list']/div[@class='paginator']/a/@href",

# 书名

'title': "//div[@id='wrapper']/h1/span/text()",

}

# 定义队列

list_queue = Queue()

detail_queue = Queue()

# 定义协程池

pool = Pool(size=10)

# 定义代理池

proxy_list = [

'118.190.147.92:15524',

'47.92.134.176:17141',

'119.23.32.38:20189',

]

# 定义UserAgent

user_agent_list = [

'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2228.0 Safari/537.36',

'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:40.0) Gecko/20100101 Firefox/40.1',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_9_3) AppleWebKit/537.75.14 (KHTML, like Gecko) Version/7.0.3 Safari/7046A194A',

'Mozilla/5.0 (Windows NT 6.1; WOW64; Trident/7.0; AS; rv:11.0) like Gecko',

]

def fetch(url):

"""发起HTTP请求"""

proxies = random.choice(proxy_list)

user_agent = random.choice(user_agent_list)

headers = {'User-Agent': user_agent}

html = requests.get(url, headers=headers, proxies=proxies).text

return html

def parse(html, rule):

"""解析页面"""

return etree.HTML(html).xpath(rule)

def crawl(url):

"""首页"""

html = fetch(url)

list_urls = parse(html, rules['list_urls'])

for list_url in list_urls:

list_queue.put(urljoin(base_url, list_url))

def list_loop():

"""采集列表页"""

while True:

list_url = list_queue.get()

pool.spawn(crawl_list_page, list_url)

def detail_loop():

"""采集详情页"""

while True:

detail_url = detail_queue.get()

pool.spawn(crawl_detail_page, detail_url)

def crawl_list_page(list_url):

"""采集列表页"""

html = fetch(list_url)

detail_urls = parse(html, rules['detail_urls'])

# 详情页

for detail_url in detail_urls:

detail_queue.put(urljoin(base_url, detail_url))

# 下一页

list_urls = parse(html, rules['page_urls'])

for list_url in list_urls:

list_queue.put(urljoin(base_url, list_url))

def crawl_detail_page(list_url):

"""采集详情页"""

html = fetch(list_url)

title = parse(html, rules['title'])[0]

print title

def run():

"""run"""

# 1. 首页

crawl(start_url)

# 2. 列表页

pool.spawn(list_loop)

# 3. 详情页

pool.spawn(detail_loop)

# 开始采集

pool.join()

if __name__ == '__main__':

run()

|

这个版本的爬虫代码,加上了随机代理和请求头,这也是突破防爬措施的常用手段,使用此手段,加上一些质量高的代理,应对一些小网站的数据抓取,不在话下。

当然,这里只为了展示一步步写爬虫、优化爬虫的思路,来达到抓取数据的目的,现实情况的抓取与反爬比想象中的更复杂,需要具体场景具体分析。

现有问题

经过上面这几步,我们想要哪个网站的数据,分析网站网页结构,写出代码应该不成问题。

抓几个网站可以这么写,但抓几十个、几百个网站,你还能写下去吗?

由此暴露的问题:

- 爬虫脚本繁多,管理困难

- 规则定义零散,重复开发

- 后台脚本,无监控

- 数据输出困难,业务接入慢

这些问题都是我们在爬虫越写越多的情况下,难免会遇到的问题。

此时,我们迫切需要一个更好的解决方案,来更好地开发爬虫,爬虫平台应运而生。

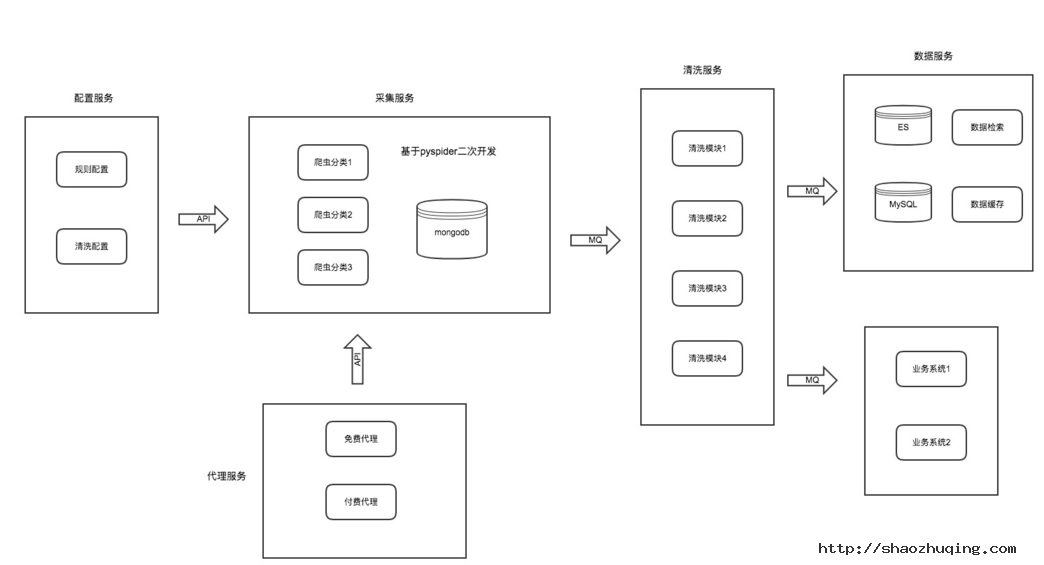

平台架构

我们来分析每个爬虫的共同点,结果发现:写一个爬虫无非就是规则、抓取、解析、入库这几步,那我们可不可以把每一块分别拆开呢?如图:

- 配置服务:包括抓取页面配置、解析规则配置、清洗配置

- 采集服务:专注网页下载与采集,并提供防爬策略

- 代理服务:提供稳定可持续输出的代理

- 清洗服务:针对同一类型业务进行字段清洗

- 数据服务:数据展示及业务数据对接

我们把一个爬虫的每一个环节,拆开做成一个个单独的服务模块,各模块各司其职。

每个模块维护属于自己领域的功能,可独立升级和优化。

详细设计

配置服务

此模块主要包括采集URL配置、页面解析规则配置、清洗配置。

我们把爬虫的规则从爬虫脚本中抽离出来,单独配置与维护,这样也便于重用与管理。

由于此模块专注配置管理,那我们可以对配置进一步拆开,配置支持各种方式的数据解析模式,如正则解析、CSS解析、XPATH解析,每种模式配置对应的表达式即可。

采集服务可以写一个配置解析器与配置服务进行对接,此配置解析器内部实现各种模式具体的解析逻辑。

清洗配置主要可配置每个爬虫输出后对应的清洗worker。

采集服务

此模块比较纯粹,就是写爬虫逻辑的模块,我们可以像之前那样开发、调试、运行爬虫脚本,但这一切工作都只能在命令行脚本进行,有没有一种好的方案是可以可视化操作的呢?

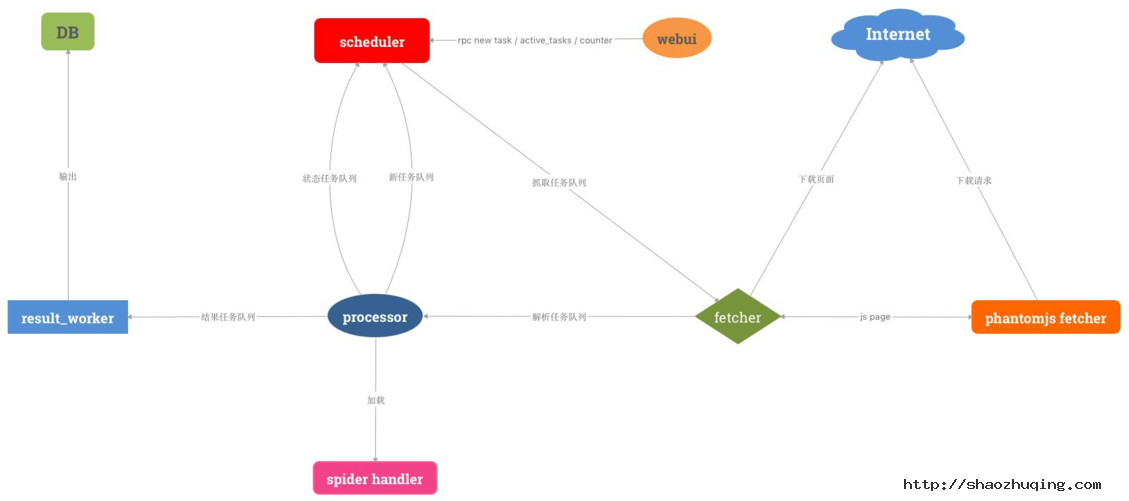

我们调研了市面上比较好的爬虫框架,发现pyspider符合我们的需求,此框架的特点:

- 支持分布式

- 配置可视化

- 可周期采集

- 支持优先级

- 任务可监控

正所谓站在巨人的肩膀上。我们决定对其进行二次开发,并增强其一些组件,使爬虫开发成本更低,更符合我们的业务规则。

- 开发配置解析器,对接配置服务

spider handler定制爬虫模板,分类采集任务,生成模板,降低开发成本fetcher新增代理调度机制,对接代理服务,并增加代理调度策略result_worker输出定制化,对接清洗服务

由此我们可做出一个分布式、可视化、任务可监控、可生成爬虫模板的采集服务模块。

代理服务

做爬虫的都知道,代理是突破防抓的常用手段,如何获取稳定且持续的代理呢?

此模块内部维护代理的质量和数量,并输出给采集服务,供采集使用。

主要包括两部分:

- 免费代理

- 付费代理

免费代理

免费代理主要由我们自己的代理采集程序采集获得,大致思路为:

- 收集代理源

- 定时采集代理

- 测试代理

- 输出代理

付费代理

免费代理的质量和稳定性相对较差,对于采集防爬比较厉害的网站,还是不够用。

这时我们会购买一些付费代理,专门用于采集这类防爬的网站,此代理一般为高匿代理,并定时更新。

清洗服务

此模块比较简单,主要接收采集服务输出的数据,然后根据对应的规则执行清洗逻辑。

例如网页字段与数据库字段归一转换,特殊字段清洗定制化等。

这个服务模块运行了很多worker,最终把输出结果输送到数据服务。

数据服务

此模块会接收最终清洗后的结构化数据,统一入库。且针对其他业务系统需要的数据进行统一推送输出:

- 数据平台展示

- 数据推送

- 数据API

解决的问题

经过这个平台的构建,基本解决了最开始困扰的几个问题:

- 爬虫管理、配置可视化

- 降低开发成本

- 进度可监控、易跟踪

- 数据输出便捷

- 业务接入迅速

爬虫技巧

爬虫技巧从整体上来说,其实核心思想就一个:尽可能地模拟人的行为。

例如:

- 随机UserAgent(github fake-useragent)

- 随机代理IP(高匿代理、代理策略)

- Cookie池

- JS渲染页面(phantomjs)

- 验证码识别(OCR、机器学习)

当然,做爬虫是一个相互博弈的过程,有时没必要硬碰硬,遇到问题换个思路不免是一种解决办法。例如,对方的PC站防抓厉害,那去看一看对方的WAP站可不可以搞一下?APP端是否可以尝试一下?在有限的成本拿到数据才是爬虫的目的。

以上就是构建一个垂直网络爬虫平台的大致思路,从最简单的爬虫脚本,到写越来越多的爬虫,到难以维护,再到整个爬虫平台的构建,一步步都是遇到问题解决问题的产物,在我们真正发现核心问题时,解决思路也就不难了。

Centos安装PHP的IMAP模块LNMP

学习记录一些 Linux 上的东西:

1.首先 ssh 连接上你的服务器:然后执行以下代码:

|

1

2

3

4

|

yum install -y libc-client-devel

ln -s /usr/lib64/libc-client.so /usr/lib/libc-client.so

ln -s /usr/lib64/libkrb5.so /usr/lib/libkrb5.so

ln -s /usr/lib64/libssl.so /usr/lib/libssl.so

|

2.然后准备安装:

|

1

2

3

4

5

6

|

#根据自己的 php 安装包路径填写 如果没有发现文件请解压相关文件夹

cd /root/lnmp1.3-full/src/php-7.0.8/ext/imap

/usr/local/php/bin/phpize

./configure -with-imap -with-php-config=/usr/local/php/bin/php-config --with-kerberos=/usr --with-imap-ssl=/usr

make

make install

|

3.然后把编译好的静态模块添加进 php.ini 文件就好:

|

1

2

3

|

vim /usr/local/php/etc/php.ini

#把下面一段代码插入最底部即可

extension = "imap.so"

|

4.然后重启 PHP:

|

1

|

lnmp php-fpm restart

|

前端解决跨域问题的8种方案(最新最全)

1.同源策略如下:

| URL | 说明 | 是否允许通信 |

|---|---|---|

| http://www.a.com/a.js http://www.a.com/b.js |

同一域名下 | 允许 |

| http://www.a.com/lab/a.js http://www.a.com/script/b.js |

同一域名下不同文件夹 | 允许 |

| http://www.a.com:8000/a.js http://www.a.com/b.js |

同一域名,不同端口 | 不允许 |

| http://www.a.com/a.js https://www.a.com/b.js |

同一域名,不同协议 | 不允许 |

| http://www.a.com/a.js http://70.32.92.74/b.js |

域名和域名对应ip | 不允许 |

| http://www.a.com/a.js http://script.a.com/b.js |

主域相同,子域不同 | 不允许 |

| http://www.a.com/a.js http://a.com/b.js |

同一域名,不同二级域名(同上) | 不允许(cookie这种情况下也不允许访问) |

| http://www.cnblogs.com/a.js http://www.a.com/b.js |

不同域名 | 不允许 |

- 特别注意两点:

- 第一,如果是协议和端口造成的跨域问题“前台”是无能为力的,

- 第二:在跨域问题上,域仅仅是通过“URL的首部”来识别而不会去尝试判断相同的ip地址对应着两个域或两个域是否在同一个ip上。

- “URL的首部”指window.location.protocol +window.location.host,也可以理解为“Domains, protocols and ports must match”。

2.前端解决跨域问题

1> document.domain + iframe (只有在主域相同的时候才能使用该方法)

1) 在www.a.com/a.html中:

2) 在www.script.a.com/b.html中:

document.domain = 'a.com';

2> 动态创建script

这个没什么好说的,因为script标签不受同源策略的限制。

function loadScript(url, func) {

var head = document.head || document.getElementByTagName('head')[0];

var script = document.createElement('script');

script.src = url;

script.onload = script.onreadystatechange = function(){

if(!this.readyState || this.readyState=='loaded' || this.readyState=='complete'){

func();

script.onload = script.onreadystatechange = null;

}

};

head.insertBefore(script, 0);

}

window.baidu = {

sug: function(data){

console.log(data);

}

}

loadScript('http://suggestion.baidu.com/su?wd=w',function(){console.log('loaded')});

//我们请求的内容在哪里?

//我们可以在chorme调试面板的source中看到script引入的内容

3> location.hash + iframe

原理是利用location.hash来进行传值。

假设域名a.com下的文件cs1.html要和cnblogs.com域名下的cs2.html传递信息。

1) cs1.html首先创建自动创建一个隐藏的iframe,iframe的src指向cnblogs.com域名下的cs2.html页面

2) cs2.html响应请求后再将通过修改cs1.html的hash值来传递数据

3) 同时在cs1.html上加一个定时器,隔一段时间来判断location.hash的值有没有变化,一旦有变化则获取获取hash值

注:由于两个页面不在同一个域下IE、Chrome不允许修改parent.location.hash的值,所以要借助于a.com域名下的一个代理iframe

代码如下:

先是a.com下的文件cs1.html文件:

function startRequest(){

var ifr = document.createElement('iframe');

ifr.style.display = 'none';

ifr.src = 'http://www.cnblogs.com/lab/cscript/cs2.html#paramdo';

document.body.appendChild(ifr);

}

function checkHash() {

try {

var data = location.hash ? location.hash.substring(1) : '';

if (console.log) {

console.log('Now the data is '+data);

}

} catch(e) {};

}

setInterval(checkHash, 2000);

cnblogs.com域名下的cs2.html:

//模拟一个简单的参数处理操作

switch(location.hash){

case '#paramdo':

callBack();

break;

case '#paramset':

//do something……

break;

}

function callBack(){

try {

parent.location.hash = 'somedata';

} catch (e) {

// ie、chrome的安全机制无法修改parent.location.hash,

// 所以要利用一个中间的cnblogs域下的代理iframe

var ifrproxy = document.createElement('iframe');

ifrproxy.style.display = 'none';

ifrproxy.src = 'http://a.com/test/cscript/cs3.html#somedata'; // 注意该文件在"a.com"域下

document.body.appendChild(ifrproxy);

}

}

a.com下的域名cs3.html

//因为parent.parent和自身属于同一个域,所以可以改变其location.hash的值 parent.parent.location.hash = self.location.hash.substring(1);

4> window.name + iframe

window.name 的美妙之处:name 值在不同的页面(甚至不同域名)加载后依旧存在,并且可以支持非常长的 name 值(2MB)。

1) 创建a.com/cs1.html

2) 创建a.com/proxy.html,并加入如下代码

<head>

<script>

function proxy(url, func){

var isFirst = true,

ifr = document.createElement('iframe'),

loadFunc = function(){

if(isFirst){

ifr.contentWindow.location = 'http://a.com/cs1.html';

isFirst = false;

}else{

func(ifr.contentWindow.name);

ifr.contentWindow.close();

document.body.removeChild(ifr);

ifr.src = '';

ifr = null;

}

};

ifr.src = url;

ifr.style.display = 'none';

if(ifr.attachEvent) ifr.attachEvent('onload', loadFunc);

else ifr.onload = loadFunc;

document.body.appendChild(iframe);

}

</script>

</head>

<body>

<script>

proxy('http://www.baidu.com/', function(data){

console.log(data);

});

</script>

</body>

3 在b.com/cs1.html中包含:

<script>

window.name = '要传送的内容';

</script>

5> postMessage(HTML5中的XMLHttpRequest Level 2中的API)

1) a.com/index.html中的代码:

<iframe id="ifr" src="b.com/index.html"></iframe>

<script type="text/javascript">

window.onload = function() {

var ifr = document.getElementById('ifr');

var targetOrigin = 'http://b.com'; // 若写成'http://b.com/c/proxy.html'效果一样

// 若写成'http://c.com'就不会执行postMessage了

ifr.contentWindow.postMessage('I was there!', targetOrigin);

};

</script>

2) b.com/index.html中的代码:

<script type="text/javascript">

window.addEventListener('message', function(event){

// 通过origin属性判断消息来源地址

if (event.origin == 'http://a.com') {

alert(event.data); // 弹出"I was there!"

alert(event.source); // 对a.com、index.html中window对象的引用

// 但由于同源策略,这里event.source不可以访问window对象

}

}, false);

</script>

6> CORS

CORS背后的思想,就是使用自定义的HTTP头部让浏览器与服务器进行沟通,从而决定请求或响应是应该成功,还是应该失败。

IE中对CORS的实现是xdr

var xdr = new XDomainRequest();

xdr.onload = function(){

console.log(xdr.responseText);

}

xdr.open('get', 'http://www.baidu.com');

......

xdr.send(null);

其它浏览器中的实现就在xhr中

var xhr = new XMLHttpRequest();

xhr.onreadystatechange = function () {

if(xhr.readyState == 4){

if(xhr.status >= 200 && xhr.status < 304 || xhr.status == 304){

console.log(xhr.responseText);

}

}

}

xhr.open('get', 'http://www.baidu.com');

......

xhr.send(null);

实现跨浏览器的CORS

function createCORS(method, url){

var xhr = new XMLHttpRequest();

if('withCredentials' in xhr){

xhr.open(method, url, true);

}else if(typeof XDomainRequest != 'undefined'){

var xhr = new XDomainRequest();

xhr.open(method, url);

}else{

xhr = null;

}

return xhr;

}

var request = createCORS('get', 'http://www.baidu.com');

if(request){

request.onload = function(){

......

};

request.send();

}

7> JSONP

JSONP包含两部分:回调函数和数据。

回调函数是当响应到来时要放在当前页面被调用的函数。

数据就是传入回调函数中的json数据,也就是回调函数的参数了。

function handleResponse(response){

console.log('The responsed data is: '+response.data);

}

var script = document.createElement('script');

script.src = 'http://www.baidu.com/json/?callback=handleResponse';

document.body.insertBefore(script, document.body.firstChild);

/*handleResonse({"data": "zhe"})*/

//原理如下:

//当我们通过script标签请求时

//后台就会根据相应的参数(json,handleResponse)

//来生成相应的json数据(handleResponse({"data": "zhe"}))

//最后这个返回的json数据(代码)就会被放在当前js文件中被执行

//至此跨域通信完成

jsonp虽然很简单,但是有如下缺点:

1)安全问题(请求代码中可能存在安全隐患)

2)要确定jsonp请求是否失败并不容易

8> web sockets

web sockets是一种浏览器的API,它的目标是在一个单独的持久连接上提供全双工、双向通信。(同源策略对web sockets不适用)

web sockets原理:在JS创建了web socket之后,会有一个HTTP请求发送到浏览器以发起连接。取得服务器响应后,建立的连接会使用HTTP升级从HTTP协议交换为web sockt协议。

只有在支持web socket协议的服务器上才能正常工作。

var socket = new WebSockt('ws://www.baidu.com');//http->ws; https->wss

socket.send('hello WebSockt');

socket.onmessage = function(event){

var data = event.data;

}

Web前端面试题目汇总

以下是收集一些面试中经常会遇到的经典面试题以及自己面试过程中有一些未解决的问题,通过对知识的整理以及经验的总结,重新巩固自身的前端基础知识,如有错误或更好的答案,欢迎指正,水平有限,望各位不吝指教。:)

HTML/CSS部分

1、什么是盒子模型?

在网页中,一个元素占有空间的大小由几个部分构成,其中包括元素的内容(content),元素的内边距(padding),元素的边框(border),元素的外边距(margin)四个部分。这四个部分占有的空间中,有的部分可以显示相应的内容,而有的部分只用来分隔相邻的区域或区域。4个部分一起构成了css中元素的盒模型。

2、行内元素有哪些?块级元素有哪些? 空(void)元素有那些?

行内元素:a、b、span、img、input、strong、select、label、em、button、textarea

块级元素:div、ul、li、dl、dt、dd、p、h1-h6、blockquote

空元素:即系没有内容的HTML元素,例如:br、meta、hr、link、input、img

3、CSS实现垂直水平居中

一道经典的问题,实现方法有很多种,以下是其中一种实现:

HTML结构:

<div class="wrapper">

<div class="content"></div>

</div> CSS:

.wrapper {

position: relative;

width: 500px;

height: 500px;

background-color: #ddd;

}

.content{

background-color:#6699FF;

width:200px;

height:200px;

position: absolute; //父元素需要相对定位

top: 50%;

left: 50%;

margin-top:-100px ; //二分之一的height,width

margin-left: -100px;

} 4、简述一下src与href的区别

href 是指向网络资源所在位置,建立和当前元素(锚点)或当前文档(链接)之间的链接,用于超链接。

src是指向外部资源的位置,指向的内容将会嵌入到文档中当前标签所在位置;在请求src资源时会将其指向的资源下载并应用到文档内,例如js脚本,img图片和frame等元素。当浏览器解析到该元素时,会暂停其他资源的下载和处理,直到将该资源加载、编译、执行完毕,图片和框架等元素也如此,类似于将所指向资源嵌入当前标签内。这也是为什么将js脚本放在底部而不是头部。

5、什么是CSS Hack?

一般来说是针对不同的浏览器写不同的CSS,就是 CSS Hack。

IE浏览器Hack一般又分为三种,条件Hack、属性级Hack、选择符Hack(详细参考CSS文档:css文档)。例如:

// 1、条件Hack

<!--[if IE]>

<style>

.test{color:red;}

</style>

<![endif]-->

// 2、属性Hack

.test{

color:#090\9; /* For IE8+ */

*color:#f00; /* For IE7 and earlier */

_color:#ff0; /* For IE6 and earlier */

}

// 3、选择符Hack

* html .test{color:#090;} /* For IE6 and earlier */

* + html .test{color:#ff0;} /* For IE7 */

6、简述同步和异步的区别

同步是阻塞模式,异步是非阻塞模式。

同步就是指一个进程在执行某个请求的时候,若该请求需要一段时间才能返回信息,那么这个进程将会一直等待下去,直到收到返回信息才继续执行下去;

异步是指进程不需要一直等下去,而是继续执行下面的操作,不管其他进程的状态。当有消息返回时系统会通知进程进行处理,这样可以提高执行的效率。

7、px和em的区别

px和em都是长度单位,区别是,px的值是固定的,指定是多少就是多少,计算比较容易。em得值不是固定的,并且em会继承父级元素的字体大小。

浏览器的默认字体高都是16px。所以未经调整的浏览器都符合: 1em=16px。那么12px=0.75em, 10px=0.625em

8、什么叫优雅降级和渐进增强?

渐进增强 progressive enhancement:

针对低版本浏览器进行构建页面,保证最基本的功能,然后再针对高级浏览器进行效果、交互等改进和追加功能达到更好的用户体验。

优雅降级 graceful degradation:

一开始就构建完整的功能,然后再针对低版本浏览器进行兼容。

区别:

a. 优雅降级是从复杂的现状开始,并试图减少用户体验的供给

b. 渐进增强则是从一个非常基础的,能够起作用的版本开始,并不断扩充,以适应未来环境的需要

c. 降级(功能衰减)意味着往回看;而渐进增强则意味着朝前看,同时保证其根基处于安全地带

9、浏览器的内核分别是什么?

IE: trident内核

Firefox:gecko内核

Safari:webkit内核

Opera:以前是presto内核,Opera现已改用Google Chrome的Blink内核

Chrome:Blink(基于webkit,Google与Opera Software共同开发)

JavaScript部分

怎样添加、移除、移动、复制、创建和查找节点?

1)创建新节点

createDocumentFragment() //创建一个DOM片段

createElement() //创建一个具体的元素

createTextNode() //创建一个文本节点

2)添加、移除、替换、插入

appendChild() //添加

removeChild() //移除

replaceChild() //替换

insertBefore() //插入

3)查找

getElementsByTagName() //通过标签名称

getElementsByName() //通过元素的Name属性的值

getElementById() //通过元素Id,唯一性

实现一个函数clone,可以对JavaScript中的5种主要的数据类型(包括Number、String、Object、Array、Boolean)进行值复制。

/**

* 对象克隆

* 支持基本数据类型及对象

* 递归方法

*/

function clone(obj) {

var o;

switch (typeof obj) {

case "undefined":

break;

case "string":

o = obj + "";

break;

case "number":

o = obj - 0;

break;

case "boolean":

o = obj;

break;

case "object": // object 分为两种情况 对象(Object)或数组(Array)

if (obj === null) {

o = null;

} else {

if (Object.prototype.toString.call(obj).slice(8, -1) === "Array") {

o = [];

for (var i = 0; i < obj.length; i++) {

o.push(clone(obj[i]));

}

} else {

o = {};

for (var k in obj) {

o[k] = clone(obj[k]);

}

}

}

break;

default:

o = obj;

break;

}

return o;

}如何消除一个数组里面重复的元素?

// 方法一:

var arr1 =[1,2,2,2,3,3,3,4,5,6],

arr2 = [];

for(var i = 0,len = arr1.length; i< len; i++){

if(arr2.indexOf(arr1[i]) < 0){

arr2.push(arr1[i]);

}

}

document.write(arr2); // 1,2,3,4,5,6在Javascript中什么是伪数组?如何将伪数组转化为标准数组?

伪数组(类数组):无法直接调用数组方法或期望length属性有什么特殊的行为,但仍可以对真正数组遍历方法来遍历它们。典型的是函数的argument参数,还有像调用getElementsByTagName,document.childNodes之类的,它们都返回NodeList对象都属于伪数组。可以使用Array.prototype.slice.call(fakeArray)将数组转化为真正的Array对象。

function log(){

var args = Array.prototype.slice.call(arguments);

//为了使用unshift数组方法,将argument转化为真正的数组

args.unshift('(app)');

console.log.apply(console, args);

};Javascript中callee和caller的作用?

caller是返回一个对函数的引用,该函数调用了当前函数;

callee是返回正在被执行的function函数,也就是所指定的function对象的正文。

请描述一下cookies,sessionStorage和localStorage的区别

sessionStorage用于本地存储一个会话(session)中的数据,这些数据只有在同一个会话中的页面才能访问并且当会话结束后数据也随之销毁。因此sessionStorage不是一种持久化的本地存储,仅仅是会话级别的存储。而localStorage用于持久化的本地存储,除非主动删除数据,否则数据是永远不会过期的。

web storage和cookie的区别

Web Storage的概念和cookie相似,区别是它是为了更大容量存储设计的。Cookie的大小是受限的,并且每次你请求一个新的页面的时候Cookie都会被发送过去,这样无形中浪费了带宽,另外cookie还需要指定作用域,不可以跨域调用。

除此之外,Web Storage拥有setItem,getItem,removeItem,clear等方法,不像cookie需要前端开发者自己封装setCookie,getCookie。但是Cookie也是不可以或缺的:Cookie的作用是与服务器进行交互,作为HTTP规范的一部分而存在 ,而Web Storage仅仅是为了在本地“存储”数据而生。

统计字符串中字母个数或统计最多字母数。

var str = "aaaabbbccccddfgh";

var obj = {};

for(var i=0;i<str.length;i++){

var v = str.charAt(i);

if(obj[v] && obj[v].value == v){

obj[v].count = ++ obj[v].count;

}else{

obj[v] = {};

obj[v].count = 1;

obj[v].value = v;

}

}

for(key in obj){

document.write(obj[key].value +'='+obj[key].count+' '); // a=4 b=3 c=4 d=2 f=1 g=1 h=1

} jQuery的事件委托方法on、live、delegate之间有什么区别?

如何理解闭包?

跨域请求资源的方法有哪些?

谈谈垃圾回收机制方式及内存管理

开发过程中遇到的内存泄露情况,如何解决的?

HTTP

一次完整的HTTP事务是怎样的一个过程?

基本流程:

a. 域名解析

b. 发起TCP的3次握手

c. 建立TCP连接后发起http请求

d. 服务器端响应http请求,浏览器得到html代码

e. 浏览器解析html代码,并请求html代码中的资源

f. 浏览器对页面进行渲染呈现给用户

HTTP的状态码有哪些?

HTTPS是如何实现加密?

算法相关

手写数组快速排序

关于快排算法的详细说明,可以参考阮一峰老师的文章快速排序

"快速排序"的思想很简单,整个排序过程只需要三步:

(1)在数据集之中,选择一个元素作为"基准"(pivot)。

(2)所有小于"基准"的元素,都移到"基准"的左边;所有大于"基准"的元素,都移到"基准"的右边。

(3)对"基准"左边和右边的两个子集,不断重复第一步和第二步,直到所有子集只剩下一个元素为止。

参考代码:

var quickSort = function(arr) {

if (arr.length <= 1) { return arr; }

var pivotIndex = Math.floor(arr.length / 2);

var pivot = arr.splice(pivotIndex, 1)[0];

var left = [];

var right = [];

for (var i = 0; i < arr.length; i++){

if (arr[i] < pivot) {

left.push(arr[i]);

} else {

right.push(arr[i]);

}

}

return quickSort(left).concat([pivot], quickSort(right));

};JavaScript实现二分法查找

二分法查找,也称折半查找,是一种在有序数组中查找特定元素的搜索算法。查找过程可以分为以下步骤:

(1)首先,从有序数组的中间的元素开始搜索,如果该元素正好是目标元素(即要查找的元素),则搜索过程结束,否则进行下一步。

(2)如果目标元素大于或者小于中间元素,则在数组大于或小于中间元素的那一半区域查找,然后重复第一步的操作。

(3)如果某一步数组为空,则表示找不到目标元素。

参考代码:

// 非递归算法

function binary_search(arr, key) {

var low = 0,

high = arr.length - 1;

while(low <= high){

var mid = parseInt((high + low) / 2);

if(key == arr[mid]){

return mid;

}else if(key > arr[mid]){

low = mid + 1;

}else if(key < arr[mid]){

high = mid -1;

}else{

return -1;

}

}

};

var arr = [1,2,3,4,5,6,7,8,9,10,11,23,44,86];

var result = binary_search(arr,10);

alert(result); // 9 返回目标元素的索引值

// 递归算法

function binary_search(arr,low, high, key) {

if (low > high){

return -1;

}

var mid = parseInt((high + low) / 2);

if(arr[mid] == key){

return mid;

}else if (arr[mid] > key){

high = mid - 1;

return binary_search(arr, low, high, key);

}else if (arr[mid] < key){

low = mid + 1;

return binary_search(arr, low, high, key);

}

};

var arr = [1,2,3,4,5,6,7,8,9,10,11,23,44,86];

var result = binary_search(arr, 0, 13, 10);

alert(result); // 9 返回目标元素的索引值 Web安全

你所了解到的Web攻击技术

(1)XSS(Cross-Site Scripting,跨站脚本攻击):指通过存在安全漏洞的Web网站注册用户的浏览器内运行非法的HTML标签或者JavaScript进行的一种攻击。

(2)SQL注入攻击

(3)CSRF(Cross-Site Request Forgeries,跨站点请求伪造):指攻击者通过设置好的陷阱,强制对已完成的认证用户进行非预期的个人信息或设定信息等某些状态更新。

前端性能

如何优化图像、图像格式的区别?

浏览器是如何渲染页面的?

设计模式

对MVC、MVVM的理解

正则表达式

写一个function,清除字符串前后的空格。(兼容所有浏览器)

function trim(str) {

if (str && typeof str === "string") {

return str.replace(/(^\s*)|(\s*)$/g,""); //去除前后空白符

}

}使用正则表达式验证邮箱格式

var reg = /^(\w)+(\.\w+)*@(\w)+((\.\w{2,3}){1,3})$/;

var email = "example@qq.com";

console.log(reg.test(email)); // true 职业规划

对前端工程师这个职位你是怎么样理解的?

a. 前端是最贴近用户的程序员,前端的能力就是能让产品从 90分进化到 100 分,甚至更好

b. 参与项目,快速高质量完成实现效果图,精确到1px;

c. 与团队成员,UI设计,产品经理的沟通;

d. 做好的页面结构,页面重构和用户体验;

e. 处理hack,兼容、写出优美的代码格式;

f. 针对服务器的优化、拥抱最新前端技术。

在服务器上排除问题的头 5 分钟

遇到服务器故障,问题出现的原因很少可以一下就想到。我们基本上都会从以下步骤入手:

一、尽可能搞清楚问题的前因后果

不要一下子就扎到服务器前面,你需要先搞明白对这台服务器有多少已知的情况,还有故障的具体情况。不然你很可能就是在无的放矢。

必须搞清楚的问题有:

- 故障的表现是什么?无响应?报错?

- 故障是什么时候发现的?

- 故障是否可重现?

- 有没有出现的规律(比如每小时出现一次)

- 最后一次对整个平台进行更新的内容是什么(代码、服务器等)?

- 故障影响的特定用户群是什么样的(已登录的, 退出的, 某个地域的…)?

- 基础架构(物理的、逻辑的)的文档是否能找到?

- 是否有监控平台可用? (比如Munin、Zabbix、 Nagios、 New Relic… 什么都可以)

- 是否有日志可以查看?. (比如Loggly、Airbrake、 Graylog…)

最后两个是最方便的信息来源,不过别抱太大希望,基本上它们都不会有。只能再继续摸索了。

二、有谁在?

$ w

$ last

用这两个命令看看都有谁在线,有哪些用户访问过。这不是什么关键步骤,不过最好别在其他用户正干活的时候来调试系统。有道是一山不容二虎嘛。(ne cook in the kitchen is enough.)

三、之前发生了什么?

$ history

查看一下之前服务器上执行过的命令。看一下总是没错的,加上前面看的谁登录过的信息,应该有点用。另外作为admin要注意,不要利用自己的权限去侵犯别人的隐私哦。

到这里先提醒一下,等会你可能会需要更新 HISTTIMEFORMAT 环境变量来显示这些命令被执行的时间。对要不然光看到一堆不知道啥时候执行的命令,同样会令人抓狂的。

四、现在在运行的进程是啥?

$ pstree -a

$ ps aux

这都是查看现有进程的。 ps aux 的结果比较杂乱, pstree -a 的结果比较简单明了,可以看到正在运行的进程及相关用户。

五、监听的网络服务

$ netstat -ntlp

$ netstat -nulp

$ netstat -nxlp

我一般都分开运行这三个命令,不想一下子看到列出一大堆所有的服务。netstat -nalp倒也可以。不过我绝不会用 numeric 选项 (鄙人一点浅薄的看法:IP 地址看起来更方便)。

找到所有正在运行的服务,检查它们是否应该运行。查看各个监听端口。在netstat显示的服务列表中的PID 和 ps aux 进程列表中的是一样的。

如果服务器上有好几个Java或者Erlang什么的进程在同时运行,能够按PID分别找到每个进程就很重要了。

通常我们建议每台服务器上运行的服务少一点,必要时可以增加服务器。如果你看到一台服务器上有三四十个监听端口开着,那还是做个记录,回头有空的时候清理一下,重新组织一下服务器。

六、CPU 和内存

$ free -m

$ uptime

$ top

$ htop

注意以下问题:

- 还有空余的内存吗? 服务器是否正在内存和硬盘之间进行swap?

- 还有剩余的CPU吗? 服务器是几核的? 是否有某些CPU核负载过多了?

- 服务器最大的负载来自什么地方? 平均负载是多少?

七、硬件

$ lspci

$ dmidecode

$ ethtool

有很多服务器还是裸机状态,可以看一下:

- 找到RAID 卡 (是否带BBU备用电池?)、 CPU、空余的内存插槽。根据这些情况可以大致了解硬件问题的来源和性能改进的办法。

- 网卡是否设置好? 是否正运行在半双工状态? 速度是10MBps? 有没有 TX/RX 报错?

八、IO 性能

$ iostat -kx 2

$ vmstat 2 10

$ mpstat 2 10

$ dstat --top-io --top-bio

这些命令对于调试后端性能非常有用。

- 检查磁盘使用量:服务器硬盘是否已满?

- 是否开启了swap交换模式 (si/so)?

- CPU被谁占用:系统进程? 用户进程? 虚拟机?

- dstat 是我的最爱。用它可以看到谁在进行 IO: 是不是MySQL吃掉了所有的系统资源? 还是你的PHP进程?

九、挂载点 和 文件系统

$ mount

$ cat /etc/fstab

$ vgs

$ pvs

$ lvs

$ df -h

$ lsof +D / /* beware not to kill your box */

- 一共挂载了多少文件系统?

- 有没有某个服务专用的文件系统? (比如MySQL?)

- 文件系统的挂载选项是什么: noatime? default? 有没有文件系统被重新挂载为只读模式了?

- 磁盘空间是否还有剩余?

- 是否有大文件被删除但没有清空?

- 如果磁盘空间有问题,你是否还有空间来扩展一个分区?

十、内核、中断和网络

$ sysctl -a | grep ...

$ cat /proc/interrupts

$ cat /proc/net/ip_conntrack /* may take some time on busy servers */

$ netstat

$ ss -s

- 你的中断请求是否是均衡地分配给CPU处理,还是会有某个CPU的核因为大量的网络中断请求或者RAID请求而过载了?

- SWAP交换的设置是什么?对于工作站来说swappinness 设为 60 就很好, 不过对于服务器就太糟了:你最好永远不要让服务器做SWAP交换,不然对磁盘的读写会锁死SWAP进程。

- conntrack_max 是否设的足够大,能应付你服务器的流量?

- 在不同状态下(TIME_WAIT, …)TCP连接时间的设置是怎样的?

- 如果要显示所有存在的连接,netstat 会比较慢, 你可以先用 ss 看一下总体情况。

你还可以看一下 Linux TCP tuning 了解网络性能调优的一些要点。

十一、系统日志和内核消息

$ dmesg

$ less /var/log/messages

$ less /var/log/secure

$ less /var/log/auth

- 查看错误和警告消息,比如看看是不是很多关于连接数过多导致?

- 看看是否有硬件错误或文件系统错误?

- 分析是否能将这些错误事件和前面发现的疑点进行时间上的比对。

十二、定时任务

$ ls /etc/cron* + cat

$ for user in $(cat /etc/passwd | cut -f1 -d:); do crontab -l -u $user; done

- 是否有某个定时任务运行过于频繁?

- 是否有些用户提交了隐藏的定时任务?

- 在出现故障的时候,是否正好有某个备份任务在执行?

十三、应用系统日志

这里边可分析的东西就多了, 不过恐怕你作为运维人员是没功夫去仔细研究它的。关注那些明显的问题,比如在一个典型的LAMP(Linux+Apache+Mysql+Perl)应用环境里:

- Apache & Nginx; 查找访问和错误日志, 直接找 5xx 错误, 再看看是否有 limit_zone错误。

- MySQL; 在mysql.log找错误消息,看看有没有结构损坏的表, 是否有innodb修复进程在运行,是否有disk/index/query 问题.

- PHP-FPM; 如果设定了 php-slow 日志, 直接找错误信息 (php, mysql, memcache, …),如果没设定,赶紧设定。

- Varnish; 在varnishlog 和 varnishstat 里, 检查 hit/miss比. 看看配置信息里是否遗漏了什么规则,使最终用户可以直接攻击你的后端?

- HA-Proxy; 后端的状况如何?健康状况检查是否成功?是前端还是后端的队列大小达到最大值了?

结论

经过这5分钟之后,你应该对如下情况比较清楚了:

- 在服务器上运行的都是些啥?

- 这个故障看起来是和 IO/硬件/网络 或者 系统配置 (有问题的代码、系统内核调优, …)相关。

- 这个故障是否有你熟悉的一些特征?比如对数据库索引使用不当,或者太多的apache后台进程。

你甚至有可能找到真正的故障源头。就算还没有找到,搞清楚了上面这些情况之后,你现在也具备了深挖下去的条件。继续努力吧!

阿里这次的地铁广告,刺穿了无数创业者的心

最近被刷屏的文案特别多,但走心的却很少……

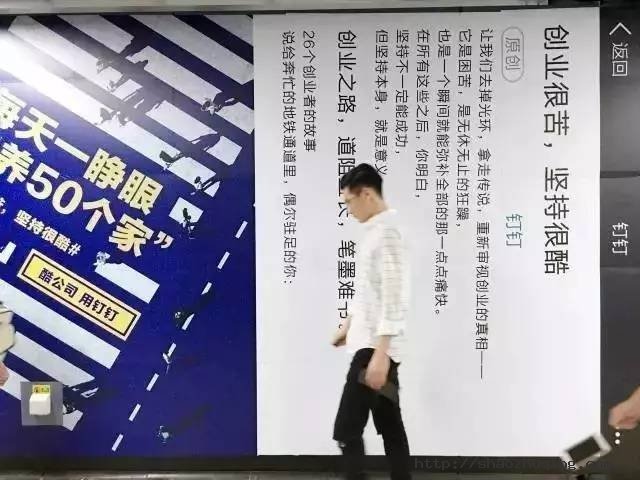

阿里钉钉最近在客村站投放了一组主题为“创业很苦,坚持很酷”的地铁广告,将26个创业故事做成了一篇微信推文,因排版怪异引发网友吐槽:治好了我多年的颈椎病……

先看我个人比较喜欢的几句:

“因为理想,成了兄弟,

因为钱,成了仇敌。”

“28岁,头发白了一半。”

“感觉自己这次会成功,

这种感觉已经是第六次。”

“陪聊陪酒赔笑,赔本。”

“怕配不上曾经的梦想,也怕辜负了所受的苦难。”

“为了想做的事儿,去做不想做的事。”

“在车里哭完,笑着走进办公室。”

“刚来三天的新同事提离职,

理由是他也决定去创业。”

“亏了钱,失去了健康。”

这样的文案总共有26组,句句扎心,有创过业的人多少都感同身受:

“没有过不去的坎儿,只有过不完的坎儿。”

“不能倒下。不想到此为止。”

“40度高烧,呆在车里,出了一身汗,然后去提案。”

“下一次,不会再为了钱低头。”

“忍受孤独”

“没有安全感的人,却要让大家有安全感”

端端正正广告的已经没人看了,创意方面得想法吸引别人的注意才行。

微信推文式广告还是第一次见:

为这张图片配一句文字:

我只是一个过客……

由此联想到钉钉去年还攻入腾讯总部楼下地铁大做撕逼广告,现在花钱买下地铁广告大方采用微信公号排版,姿态可以说是发生了180度的大转变。

这样的转变,并不意外。从策略上来说,创业产品在初期阶段,为了能快速建立差异化的认知,往往会采取比较激进的手段,而随着产品用户数越来越大,影响力越来越强,也需要照顾品牌的长线发展,注重其在公众的口碑。

世界上的公司分两种:第一种是酷公司

他们认为适应时代酷,而保持老样子不酷;拥有不酷,与更多人共享非常酷;征服者不酷,守护者很酷。

是无数个这样的酷公司,造就了今天这个酷时代……

除此以外的,我们只能称之为“其它公司”,酷公司各不相同,但他们都选择了同一种更酷的工作方式:酷公司,用钉钉。

“为了做社交软件,放弃社交。”

“只要风停了,什么猪都能摔死。”

“通宵练习了10个版本的BP,没有见到1个投资人。”

“把房子卖了,把工资发了。”

“每天一睁眼要养50个家。”

也许在未来,说不定我们还会看到有“中国酷公司”、“中国酷员工”、“中国酷老板”、“中国酷项目”、“中国酷办公室”这类的榜单被释放出来。

但“酷”的背后是互联网的协作、平等、分享的精神,以后如果以酷的形式随波逐流的话,不知道会有多少企业会买单。

针对此次阿里钉钉的广告,网友有话说:

可能钉钉这次的广告针对人群不一样,所以或多或少有一些负面信息。但是此次钉钉的主题就是为创业者所做,作为一个局外人,我只能说文案很符合创业者的心声。

同时作为不是创业者的我,看完文案都有种似曾相似的感触~

对此,你怎么看?

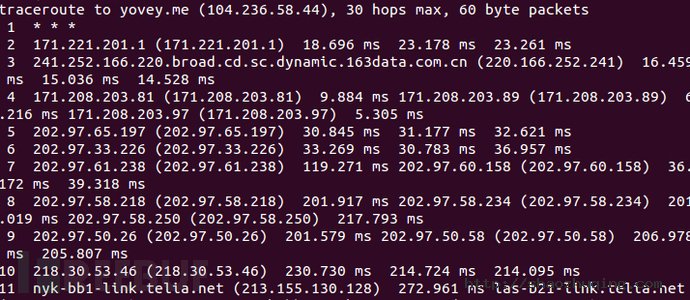

记一次对 G-F-W 防火墙的探究

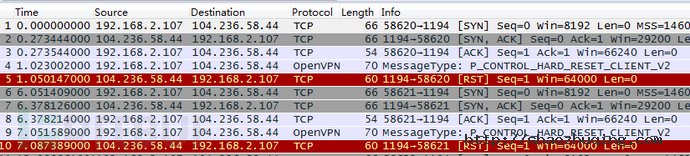

突然朋友传了一个数据包给我,说他的openVPN连不上了。

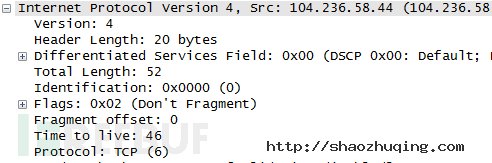

抓包发现刚一握手结束便收到了一个RST包,导致一直连不上。我打开数据包,发现果然如此:

可以看到,三次握手刚完毕,客户端发送第一个控制消息到服务端,便收到了服务端发送的RST数据包,一直如此。

应该是有中间设备搞的鬼,于是我又到服务器端抓取了些数据:

果然的,服务器也收到了RST数据包,于是两者的连接便断开了。

再仔细分析下客户端的RST数据包:

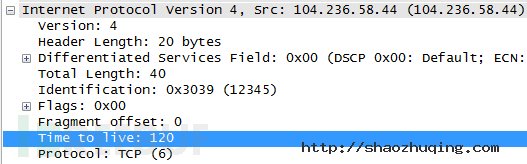

IP包的序号是12345,TTL是120。再看正常的数据包:

IP包的序号是0,TTL是46。很明显RST数据包的TTL比正常的要大,而且每次RST的IP序号都是12345,应该是GFW没错了。

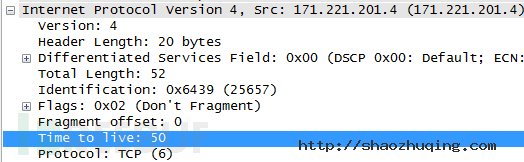

正常情况下初始的TTL是64,正常收到的TTL是46,跳数是15,说明我的电脑到服务器之间经过了15个路由设备。

为了证明这点,查看服务端收到的正常数据包:

服务器收到的TTL是50,因为我的电脑还要经过内部的一个路由器,所以TTL差了1。

同时查看服务端RST数据包的TTL值:

TTL值为117,因此得到的信息如下:

客户端->服务器:15、GWF->服务器:117、GFW->客户端:120。

假设GFW每次发送的TTL值都固定不变且为x,则有:x-117+x-120=15;得x=126。

所以GFW和我的电脑的跳数应该是6:

图示的应该就是GFW的位置。

接下来问题来了,她是怎么识别出openVPN流量的呢?

我猜测是根据数据包的特征来识别的,那么我单独发送单个数据包,应该也会返回RST数据,根据这一理论,我用scapy发送了单个的数据包,内容和三次握手之后客户端发送的第一个数据包一样,但结果是失望的,并没有收到RST数据包。

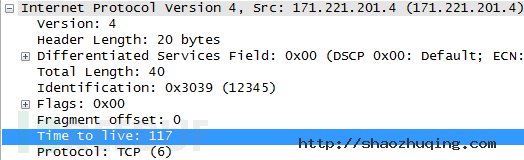

于是进一步猜测,TCP连接之后再发送相应的数据包,应该能收到RST,于是又根据这一理论,写下了如下代码:

from scapy.all import * vpn_payload = "\x00\x0e\x38\x24\x5d\x21\xaa\x3a\x11\x2f\xb3\x00\x00\x00\x00\x00" conf.verb = 0 vpn_s = IP(dst="yovey.me",id=12345)/TCP(sport=58620,dport=1194,flags="S",seq=0) print "sending syn" vpn_s.show() ans0,unans0 = sr(vpn_s) print "recv packet,seq = ",ans0[0][1].seq ans0[0][1].show() vpn_sa = IP(dst="yovey.me",id=12346)/TCP(sport=58620,dport=1194,flags="A",seq=1,ack=ans0[0][1].seq+1) print "sending ack" vpn_sa.show() ans1,unasn1 = sr(vpn_sa,timeout=1) vpn = IP(dst="yovey.me",id=12347)/TCP(sport=58620,dport=1194,flags="PA",seq=1,ack=ans0[0][1].seq+1)/vpn_payload print "sending vpn payload" ans2,unasn2 = sr(vpn) ans2[0][1].show()

运行程序,还是没有收到RST数据包。

于是我打开tcpdump,抓取了发包过程的数据包,发现了问题:

在服务器返回syn+ack之后,客户端居然发送了RST到服务器,导致连接断开。经过短暂的思考,才明白客户端网卡在收到来自服务器的syn+ack之后,发现并没有进程在监听该数据包的端口,于是发送了RST数据包给服务器。

必须让客户端不发送RST数据包才行,想到可以通过iptable来过滤数据包,于是在iptable中添加如下规则:

iptables -t filter -A OUTPUT -p tcp --tcp-flags RST RST -j DROP

再运行程序,一切都在计划之中:

还是熟悉的IP序号,还是熟悉的TTL,看来GFW已经可以根据连接来识别流量了,真是下了血本啊。

想到建立连接,我立马联想到不用建立连接的UDP,是不是UDP数据只需要根据单个数据包就能识别了?于是将服务器配置成UDP模式,再次打开openVPN,特么的居然连上了!于是问题解决了,将配置改成UDP就能正常连接了。

介绍一下GFW的工作原理和封锁技术

GFW是Great Fire Wall的缩写,即“长城防火墙”。这个工程由若干个部分组成,实现不同功能。长城防火墙主要指TG监控和过滤互联网内容的软硬件系统,由服务器和路由器等设备,加上相关的应用程序所构成。

首先,需要强调的是,由于中国网络审查广泛,中国国内含有“不合适”内容的的网站,会受到政府直接的行政干预,被要求自我审查、自我监管,乃至关闭,所以GFW的主要作用在于分析和过滤中国境内外网络的资讯互相访问。

GFW对网络内容的过滤和分析是双向的,GFW不仅针对国内读者访问中国境外的网站进行干扰,也干扰国外读者访问主机在中国大陆的网站。

一 关键字过滤阻断

关键字过滤系统。此系统能够从出口网关收集分析信息,过滤、嗅探指定的关键字。主要针对HTTP的默认端口:80端口,因为HTTP传播的内容是明文的内容,没有经过加密,而GFW是一个IDS(Intrusion detection system)。普通的关键词如果出现在HTTP请求报文的头部(如“Host: www.youtube.com”)时,则会马上伪装成对方向连接两端的计算机发送RST包(reset)干扰两者正常的TCP连接,进而使请求的内容无法继续查看。如果GFW在数据流中发现了特殊的内文关键词(如轮子,达赖等)时,其也会试图打断当前的连接,从而有时会出现网页开启一部分后突然停止的情况。在任何阻断发生后,一般在随后的90秒内同一IP地址均无法浏览对应IP地址相同端口上的内容。

二 IP地址封锁

IP地址封锁是GFW通过路由器来控制的,在通往国外的最后一个网关上加上一条伪造的路由规则,导致通往某些被屏蔽的网站的所有IP数据包无法到达。路由器的正常工作方式是学习别的路由器广播的路由规则,遇到符合已知的IP转发规则的数据包,则按已经规则发送,遇到未知规则IP的数据,则转发到上一级网关。

而GFW对于境外(中国大陆以外)的XX网站会采取独立IP封锁技术。然而部分XX网站使用的是由虚拟主机服务提供商提供的多域名、单(同)IP的主机托管服务,这就会造成了封禁某个IP地址,就会造成所有使用该服务提供商服务的其它使用相同IP地址服务器的网站用户一同遭殃,就算是正常的网站,也不能幸免。其中的内容可能并无不当之处,但也不能在中国大陆正常访问。现在GFW通常会将包含XX信息的网站或网页的URL加入关键字过滤系统,并可以防止民众透过普通海外HTTP代理服务器进行访问。

三 特定端口封锁

GFW会丢弃特定IP地址上特定端口的所有数据包,使该IP地址上服务器的部分功能(如SSH的22、VPN的1723或SSL的443端口等)无法在中国大陆境内正常使用。

在中国移动、中国联通等部分ISP(手机IP段),所有的PPTP类型的VPN都被封锁。

2011年3月起,GFW开始对Google部分服务器的IP地址实施自动封锁(按时间段)某些端口,按时段对www.google.com(用户登录所有Google服务时需此域名加密验证)和mail.google.com的几十个IP地址的443端口实施自动封锁,具体是每10或15分钟可以连通,接着断开,10或15分钟后再连通,再断开,如此循环,令中国大陆用户和Google主机之间的连接出现间歇性中断,使其各项服务出现问题。GFW这样的封锁手法很高明,因为Gmail并非被完全阻断,这令问题看上去好像出自Google本身。这就是你们认为Google抽风的原因。

四 SSL连接阻断

GFW会阻断特定网站的SSL加密连接,方法是通过伪装成对方向连接两端的计算机发送RST包(RESET)干扰两者间正常的TCP连接,进而打断与特定IP地址之间的SSL(HTTPS,443端口)握手(如Gmail、Google文件、Google网上论坛等的SSL加密连接),从而导致SSL连接失败。

当然由于SSL本身的特点,这并不意味着与网站传输的内容可被破译。

五 DNS劫持和污染

GFW主要采用DNS劫持和污染技术,使用Cisco提供的IDS系统来进行域名劫持,防止访问被过滤的网站,2002年Google被封锁期间其域名就被劫持到百度。中国部分ISP也会通过此技术插入广告。

对于含有多个IP地址或经常变更IP地址逃避封锁的域名,GFW通常会使用此方法进行封锁。具体方法是当用户向DNS服务器提交域名请求时,DNS返回虚假(或不解析)的IP地址。

全球一共有13组根域名服务器(Root Server),目前中国大陆有F、I这2个根域DNS镜像,但现在均已因为多次DNS污染外国网络,而被断开与国际互联网的连接。

DNS劫持和污染是针对某些网站的最严重的干扰。

干扰的方式有两种:

一种是通过网络服务提供商(Internet Service Provider)提供的DNS服务器进行DNS欺骗,当人们访问某个网站时,需要要把域名转换为一个IP地址,DNS服务器负责将域名转换为IP地址,中国大陆的ISP接受通信管理局的屏蔽网站的指令后在DNS服务器里加入某些特定域名的虚假记录,当使用此DNS服务器的网络用户访问此特定网站时,DNS服务便给出虚假的IP地址,导致访问网站失败,甚至返回ISP运营商提供的出错页面和广告页面。

另一种是GFW在DNS查询使用的UDP的53端口上根据blacklist进行过滤,遇到通往国外的使用UDP53端口进行查询的DNS请求,就返回一个虚假的IP地址。